Ein KI-Tool wie ChatGPT mit Suchfunktion funktioniert ganz anders als eine Suchmaschine. Entsprechend schlecht sind die Suchergebnisse.

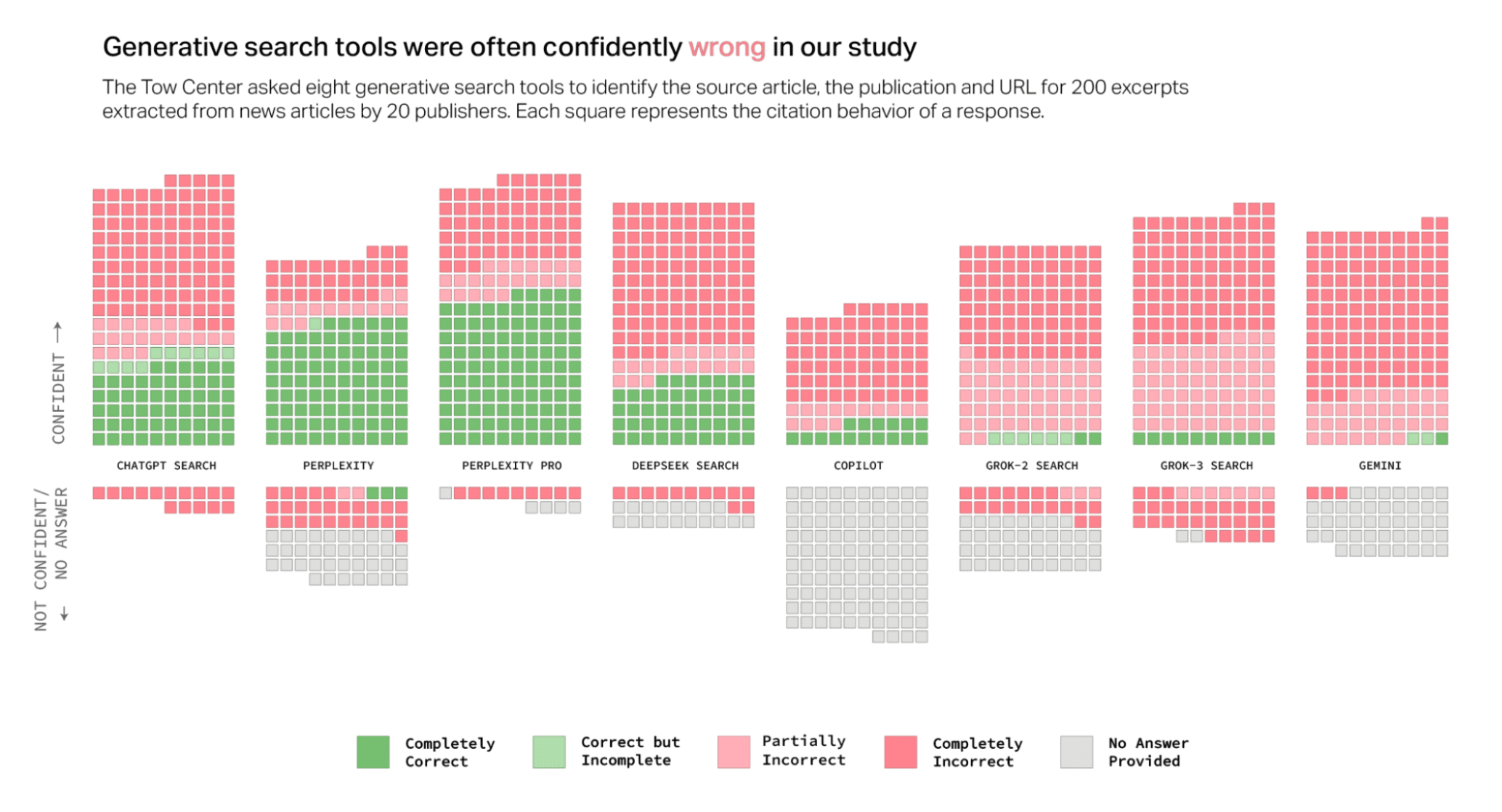

Zum Beispiel haben zwei Medienschaffende kürzlich untersucht, wie gut acht «KI-Suchmaschinen» wie ChatGPT, Gemini oder Copilot funktionieren. Auch Perplexity wurde getestet, eine Suchmaschine mit KI-Funktion.

Das Ergebnis ist eindeutig: «KI-Suchmaschinen» liefern häufig falsche oder erfundene Quellenangaben. Insgesamt beantworteten sie mehr als 60 Prozent der Anfragen falsch.

Dabei variiert der Grad der Ungenauigkeit je nach Plattform. Zum Beispiel beantwortete Perplexity 37 Prozent der Anfragen falsch, bei Grok 3 waren 94 Prozent der Anfragen falsch.

Die «KI-Suchmaschinen» hatten zum Beispiel Mühe, Nachrichtenartikel korrekt zu identifizieren, zu verlinken und die ursprünglichen Herausgeber zu nennen.

🔎 Detaillierte Ergebnisse: AI Search Has A Citation Problem (6.3.2025)

🔎 Mein wöchentliches Briefing enthält diese und viele weitere nützliche Informationen. Gleichzeitig bestätigen solche Test-Ergebnisse die Wichtigkeit, KI-Tools verantwortungsvoll einzusetzen und über eine KI-Leitlinie zu verfügen. Zu diesen Themen biete ich regelmässig Kurse an, die auf meiner Website ausgeschrieben sind.